Meta Llama 3.1 405B resmen duyuruldu ve yapay zeka özellikleri şimdiden dikkatleri üzerine topladı. Meta tarafından geliştirilen bu model, kapalı kaynaklı en iyi yapay zeka modellerine rakip olabilecek performans sunuyor. Bazı kullanıcılar şimdiden bu yeni modeli deneyimleme fırsatı buldu. Şimdi ise benchmark sonuçlarıyla birlikte buradayız.

Meta Llama 3.1 405B nedir?

Meta Llama 3.1 405B, genel bilgi, matematik, araç kullanımı ve çok dilli çeviri gibi çeşitli görevlerde destek sağlayan açık kaynaklı bir yapay zeka modelidir. 128K bağlam uzunluğu ve sekiz dil desteğiyle bu model, birçok yapay zeka tutkununun işine yarayacak gibi. 16 binden fazla H100 GPU kullanılarak 15 trilyondan fazla token üzerinde eğitilen Llama 3.1 405B, mevcut en güçlü ve yetenkli yapay zeka modellerinden biri olma yolunda ilerliyor.

Meta Llama 3.1 405B’nin özellikleri

Meta Llama 3.1 405B, birkaç gelişmiş özellik sunuyor:

- Genişletilmiş bağlam uzunluğu: 128K’ya kadar bağlam uzunluğunu destekler, uzun biçimli metin özetleri ve karmaşık konuşmalar için idealdir,

- Çoklu dil desteği: Birden fazla dili destekler, bu sayede global uygulamalar için çok yönlüdür,

- Entegrasyon: Gelişmiş işlevsellik için çeşitli araçlarla entegre olma yeteneği,

- Sentetik veri üretimi: Daha küçük modellerin iyileştirilmesi ve eğitilmesi için sentetik verilerin oluşturulmasını kolaylaştırır,

- Model dönüştürme: Büyük modellerin daha küçük ve daha verimli versiyonlara dönüştürülmesini sağlar.

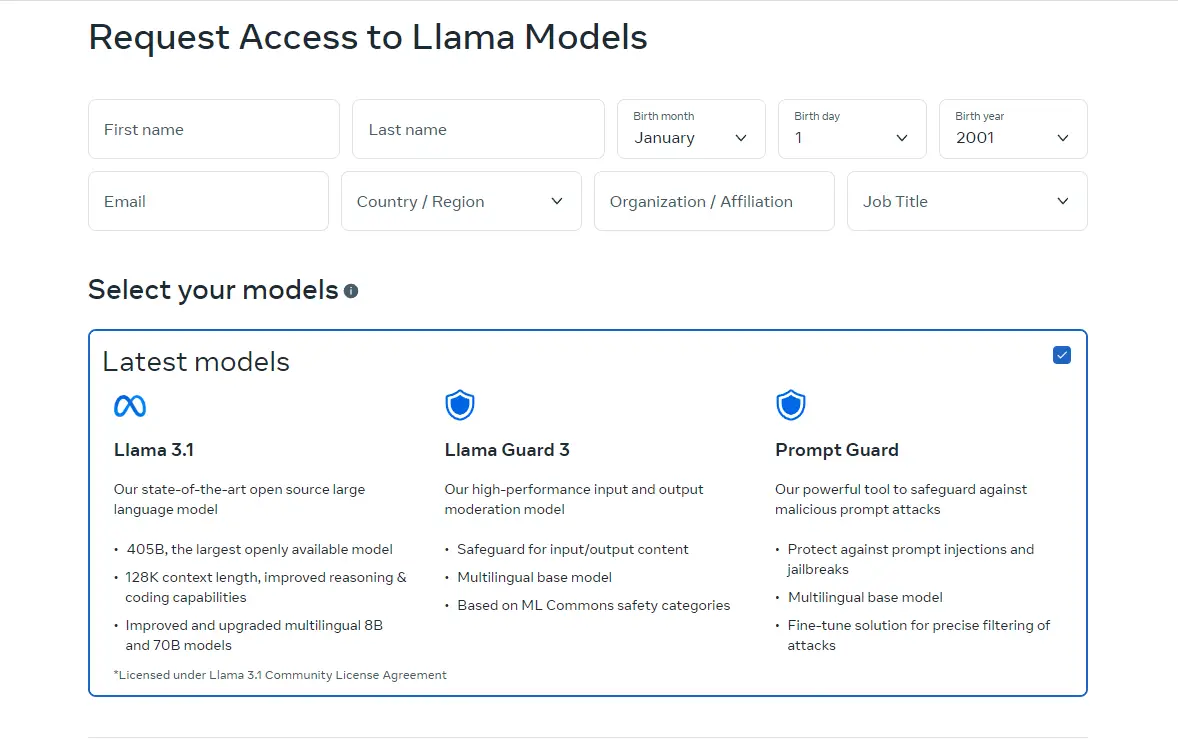

Meta Llama 3.1 405B nasıl kullanılır?

Meta Llama 3.1 405B’yi kullanmaya başlamak için şu adımları izleyin:

- Modele erişim: Modele erişim maalesef Türkiye’de şu an için mümkün değil. Ancak ilerleyen zamanlarda kullanıma sunulursa, aşağıdaki adımları takip edebilirsiniz.

- Ortamınızı ayarlayın: Modeli çalıştırmak için uygun bir ortama sahip olduğunuzdan emin olun. Bu, GPU’lar gibi gerekli donanıma ve Python ve PyTorch gibi yazılım bağımlılıklarına sahip olmayı içerir.

- Modeli yükleyin: Modeli uygulamanıza yüklemek için sağlanan kod parçacıklarını ve yönergeleri kullanın. Meta, Llama 3.1 405B’yi projelerinize entegre etmenize yardımcı olacak ayrıntılı talimatlar sağlar.

- Modeli kullanmaya başlayın: Modeli gerçek zamanlı veya toplu çıkarım için kullanmaya başlayın. Modele sorular sorabilir, metin üretebilir veya güçlü yeteneklerini kullanarak çeviriler yapabilirsiniz.

- İnce ayar yapın: Gerekirse, denetlenen ince ayar tekniklerini kullanarak modeli belirli uygulamalar için ince ayarlayabilirsiniz. Meta, bu süreçte size rehberlik edecek kaynaklar ve örnekler sunar.

Meta Llama 3.1 405B’yi Groq’ta kullanabilirsiniz

Türkiye’deki kullanıcılar için bir müjdemiz var. Meta Llama 3.1 405B, Groq’ta da kullanılabilir. İşte yapmanız gerekenler:

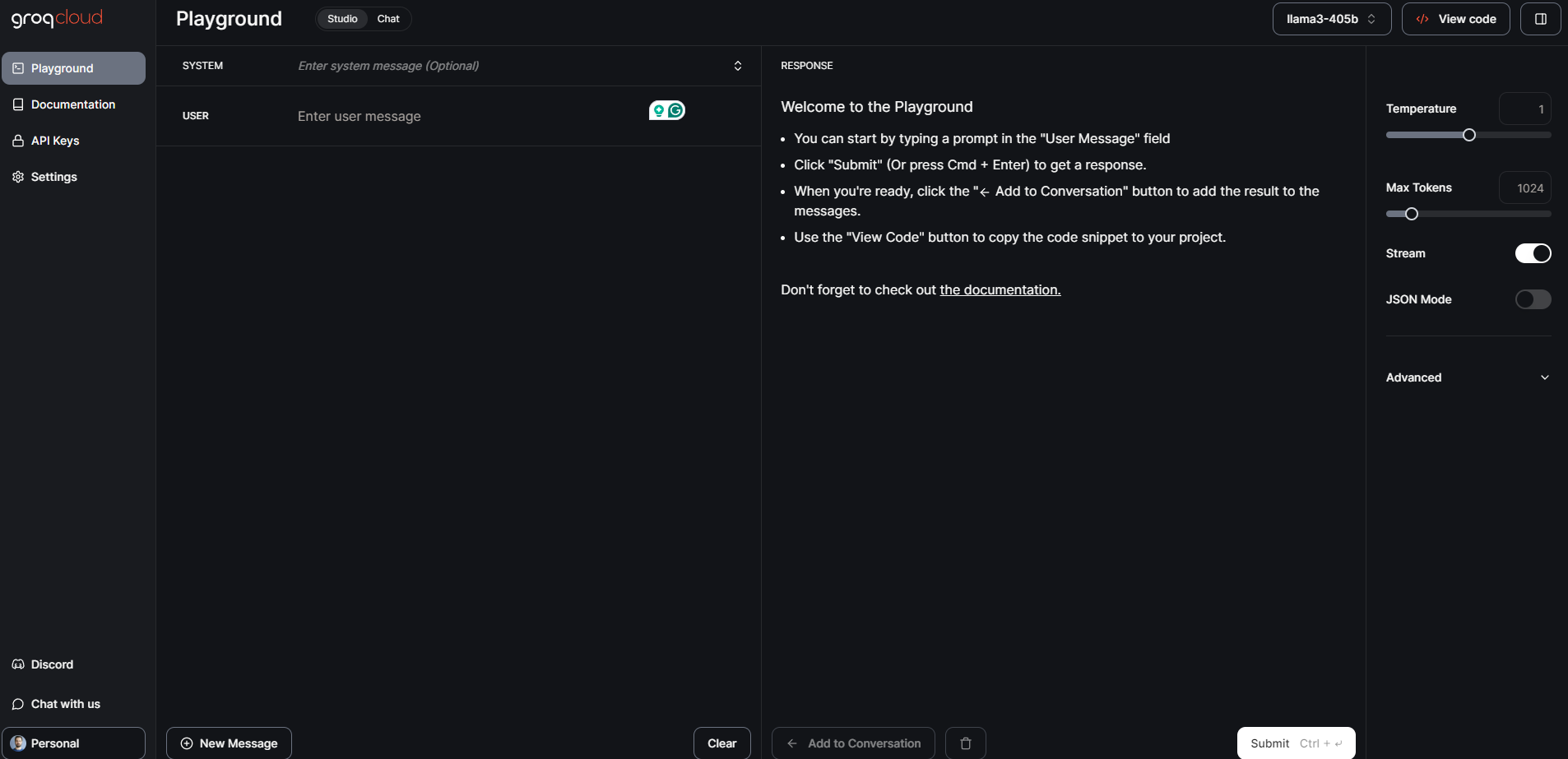

- İlk olarak GroqCloud’un web sitesine gidin,

- Hesabınız yoksa yeni bir hesap oluşturun,

- Hesabınıza giriş yaptıktan sonra modellerin olduğu menüde Meta Llama 3.1 405B’yi bulun,

Groq web sitesinden ekran görüntüsü - Uygun donanım ve yazılım gereksinimlerini karşıladığınızdan emin olun. API entegrasyonu için gerekli yapılandırmaları gerçekleştirin,

- GroqCloud Dev Console’da sağlanan kodları kullanarak modeli uygulamanıza yükleyin ve başlatın,

Groq web sitesinden ekran görüntüsü - Veri kümenizi hazırlayın ve modeli denetlenen teknikler kullanarak düzgünce ayarlayın.

Meta Llama 3.1 405B: Benchmark testleri ve performans

Meta Llama 3.1 405B, çeşitli görevlerde olağanüstü performans gösterdiğini doğrulayan resmi kıyaslama testlerine tabi tutuldu. Model, 150’den fazla kıyaslama veri kümesinde değerlendirildi ve GPT-4 ve Claude 3.5 Sonnet gibi önde gelen modellerle karşılaştırıldı. Sonuçlar, Llama 3.1 405B’nin bu en iyi modellerle rekabet edebildiğini ve gerçek dünya senaryolarında yüksek kaliteli performans sağladığını gösteriyor.

Öncelikle Llama 3.1 8B ve Llama 3.1 70B benchmark’larına bakalım. Bu benchmark’ları tablo şeklinde aşağıda görebilirsiniz:

| Category | Benchmark | Llama 3.1 8B | Gemma 2 9B IT | Mistral 7B Instruct | Llama 3.1 70B | Mixtral 8x22B Instruct | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| General | MMLU (0-shot, CoT) | 73.0 | 72.3 | 60.5 | 86.0 | 79.9 | 69.8 |

| General | MMLU PRO (5-shot, CoT) | 48.3 | – | 36.9 | 66.4 | 56.3 | 49.2 |

| General | IFEval | 80.4 | 73.6 | 57.6 | 87.5 | 72.7 | 69.9 |

| Code | HumanEval (0-shot) | 72.6 | 54.3 | 40.2 | 80.5 | 75.6 | 68.0 |

| Code | MBPP EvalPlus (base) (0-shot) | 72.8 | 71.7 | 49.5 | 86.0 | 78.6 | 82.0 |

| Math | GSM8K (8-shot, CoT) | 84.5 | 76.7 | 53.2 | 95.1 | 88.2 | 81.6 |

| Math | MATH (0-shot, CoT) | 51.9 | 44.3 | 13.0 | 68.0 | 54.1 | 43.1 |

| Reasoning | ARC Challenge (0-shot) | 83.4 | 87.6 | 74.2 | 94.8 | 88.7 | 83.7 |

| Reasoning | GPQA (0-shot, CoT) | 32.8 | – | 28.8 | 46.7 | 33.3 | 30.8 |

| Tool use | BFCL | 76.1 | – | 60.4 | 84.8 | – | 85.9 |

| Tool use | Nexus | 38.5 | 30.0 | 24.7 | 56.7 | 48.5 | 37.2 |

| Long context | ZeroSCROLLS/QuALITY | 81.0 | – | – | 90.5 | – | – |

| Long context | InfiniteBench/En.MC | 65.1 | – | – | 78.2 | – | – |

| Long context | NIH/Multi-needle | 98.8 | – | – | 97.5 | – | – |

| Multilingual | Multilingual MGSM (0-shot) | 68.9 | 53.2 | 29.9 | 86.9 | 71.1 | 51.4 |

405B modelinin benchmark’ları:

| Category | Benchmark | Llama 3.1 405B | Nemotron 4 340B Instruct | GPT-4 (0125) | GPT-4 Omni | Claude 3.5 Sonnet |

|---|---|---|---|---|---|---|

| General | MMLU (0-shot, CoT) | 88.6 | 78.7 (non-CoT) | 85.4 | 88.7 | 88.3 |

| General | MMLU PRO (5-shot, CoT) | 73.3 | 62.7 | 64.8 | 74.0 | 77.0 |

| General | IFEval | 88.6 | 85.1 | 84.3 | 85.6 | 88.0 |

| Code | HumanEval (0-shot) | 89.0 | 73.2 | 86.6 | 90.2 | 92.0 |

| Code | MBPP EvalPlus (base) (0-shot) | 88.6 | 72.8 | 83.6 | 87.8 | 90.5 |

| Math | GSM8K (8-shot, CoT) | 96.8 | 92.3 (0-shot) | 94.2 | 96.1 | 96.4 (0-shot) |

| Math | MATH (0-shot, CoT) | 73.8 | 41.1 | 64.5 | 76.6 | 71.1 |

| Reasoning | ARC Challenge (0-shot) | 96.9 | 94.6 | 96.4 | 96.7 | 96.7 |

| Reasoning | GPQA (0-shot, CoT) | 51.1 | – | 41.4 | 53.6 | 59.4 |

| Tool use | BFCL | 88.5 | 86.5 | 88.3 | 80.5 | 90.2 |

| Tool use | Nexus | 58.7 | – | 50.3 | 56.1 | 45.7 |

| Long context | ZeroSCROLLS/QuALITY | 95.2 | – | – | 90.5 | 90.5 |

| Long context | InfiniteBench/En.MC | 83.4 | – | 72.1 | 82.5 | – |

| Long context | NIH/Multi-needle | 98.1 | – | 100.0 | 100.0 | 90.8 |

| Multilingual | Multilingual MGSM (0-shot) | 91.6 | – | 85.9 | 90.5 | 91.6 |

Meta Llama 3.1 405B, gelişmiş özellikleri ve geniş ekosistem desteği ile yapay zeka topluluğuna önemli katkılar sunuyor. Bu güçlü modelin, çeşitli uygulamalar için etkileyici çözümler sunarak yapay zekanın geleceğinde önemli bir rol oynayacağını umuyoruz.

Öne çıkan görsel kaynağı: MetaAI